文 | 颜璇

来源 | 智能相对论(aixdlun)

从古至今,“欺骗”和“造假”这两个词可谓是贯穿了人类的历史。到了现代社会,面对着互联网上那些似是而非的庞杂信息,“有图有真相”开始成为网友们的诉求。

可以看出,绝大多数人都是认同一点的——只有拿出坚实的证据,才能证明你说的就是真相。将这些证据的说服力排一个序,大概是文本>照片>音频>视频。

然而,随着PS的兴起,“照骗”渐渐失去了人们的信任,音频和视频已经被视为更可靠的证据来源,但是,在AI入军短视频制作后,事情正在发生着改变。在未来,人们可能需要处理更多真假难辨的音视频。

AI在视频造假上的进阶之路

在寻常人看来,短视频造假的方式无非就是一些“断章取义”的剪辑罢了。然而,AI可没那么简单,在短视频“造假”上,它不止要以假乱真,更要无中生有。通常来说,AI在短视频上造假的方式有以下三种:

1. 初级阶段:移花接木

在短视频“造假术”里,最重要的不是图像的拼接,而是音频的连续性。想一想,即使你将奥巴马和特朗普两个人的视频剪辑在一起,想要告诉大家他们“同台演出”了,没有他们讲话的声音,其效果大概就等于N张静态照片叠加而已。

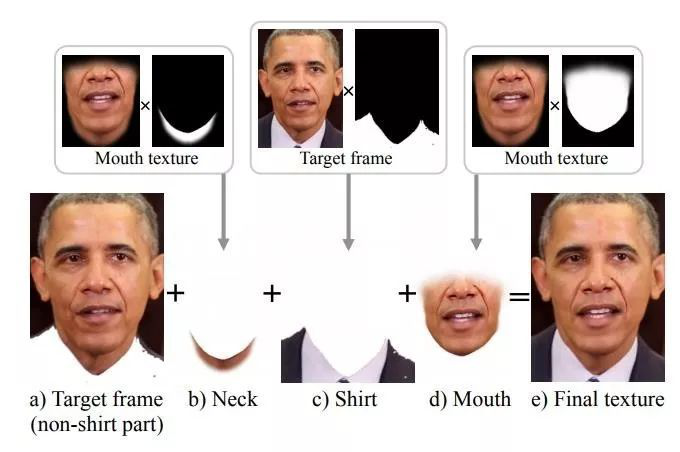

AI正在试图合成人们在实际中从未说过的话。研究人员就曾利用奥巴马的演讲视频训练AI的学习系统,让系统的神经网络学会如何将各种语音特征与对应的口型联系在一起,生成CGI唇动,在3D姿态匹配的帮助下将CGI唇动与奥巴马的视频整合在一起。也就是说,他们能够利用相关音轨伪造一段令人难辨真伪的视频。

利用AI系统,用户可以任意编辑人类语音,Adobe曾表示它可以像 Photoshop 编辑图片一样用于调整视频中的发音和对话。我们现在可以创建政治家、名人、演说家的视频片段,并且不论内容如何。

2. 中级阶段:改头换面

在这个阶段里,AI就不是合成了,而是对视频里的内容进行编辑。通过人脸检测和五官识别,对人脸的关键点实时追踪,让人们在动态视频中可以对自己脸进行改造。

这一技术属于动作捕捉技术中的一个分支,叫面部捕捉。这些脸上的黄点,就是人脸表情变化中的关键点,通过面部追踪,计算机只需要这些信息就能合成表情。

近日,微视就发布了安卓4.4版本,推出了实时美妆、五官重塑等新功能,包括此前已在iOS版本上线的实时长腿、音控魔法功能,也在安卓上同步更新。

视频里化妆都是小儿科了,AI还能在视频里给你换脸呢。在电影《星球大战外传:侠盗一号》中,技术人员通过捕捉一位现代演员盖·亨利的表情,合成了另外一位已经逝世的演员彼得·库欣,使其再次出现在了大荧幕上。

3. 高级阶段:无中生有

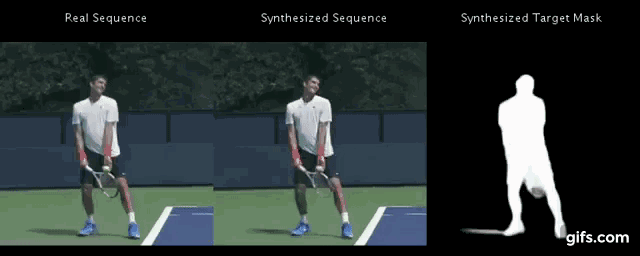

合成声音尚能理解,合成动作你敢相信吗?近日,在MIT(麻省理工学院)的论文Synthesizing Images of Humans in Unseen Poses中,研究人员提出了一种模块化的生成神经网络,用从人类运动视频中提取的成对图像和姿势训练之后,它能够为一个人合成出没做过的新姿势。而且,这个模型在没有经过刻意训练的情况下,能够生成一段连续的视频。

也就是说,单凭一张照片,AI就能随意摆布照片中的人,使人物作出一系列动作,视频的合成非常自然。

(图为该技术合成的网球运动视频 GIF来源:量子位 公众号)

这当然只是新技术的冰山一角,我们很难对现代人工智能的视频处理技术做出全面的概述,但我们总能从中找出一些有意思的应用。例如:从一张 2D 图片中创建 3D 面部模型;改变视频中的光源和阴影;在总统选举直播中让特朗普变成秃头等等。

伪造与证伪的技术总是交互上升

不得不说,AI确实具有很强的视频造假能力。但我们也逐渐意识到了视频造假的危害。随意放在网上的视频和声音都需要我们去认真辨别,如果有非法分子利用该技术进行信息诈骗,我们虽然不是权贵,但也经不起损失。

尤其在新闻业,一旦人们知道目前有伪造的视频和音频在传播,即使他们看到的是真实视频,也会开始产生怀疑。所以,如果AI能够让我们像处理图片一样轻松处理音频、视频内容,这其实在某种程度上削弱了媒体的可信度。

幸运的是,道高一尺,魔高一丈,伪造与证伪的技术总是交互上升。这就是一场“军备竞赛”。AI让越来越多的人都有能力进行伪造,但研究人员也不断在开发更加精密的技术来增强音频、图片和和视频的鉴别。通过不断增加造假难度,使得非法分子造假的成本和技能要求越来越高。

现在,鉴别AI所做的伪造和处理其实并不难,模糊处理是一种最常见的方法,低分辨率就会让它“一看就是假的。”

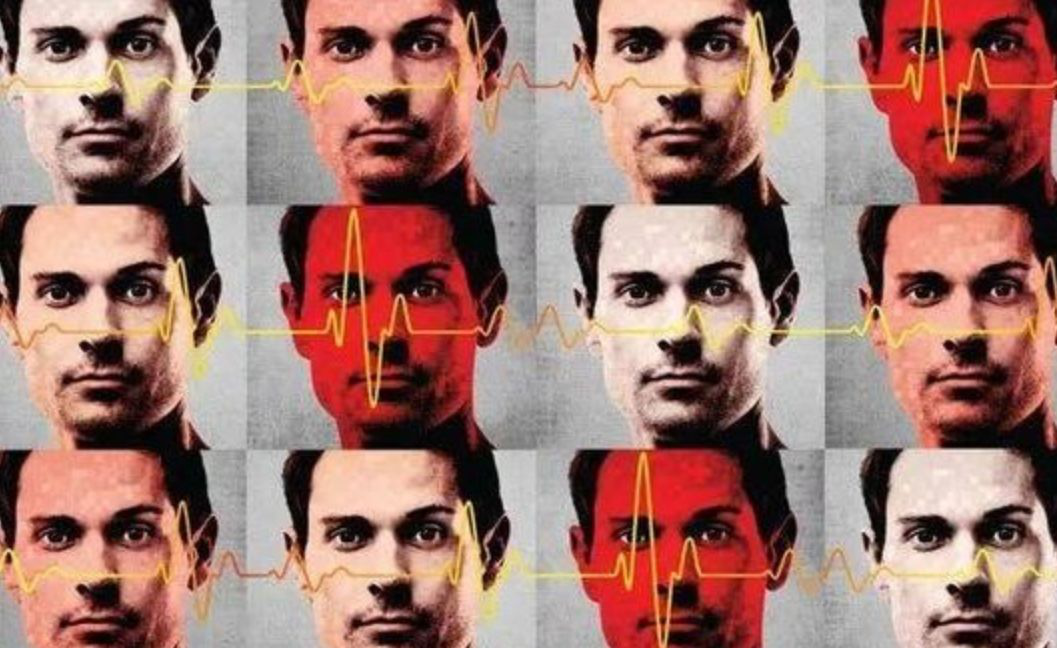

除了画质,还有画幅的甄别。在短视频里,画面里的一点改动凭借人的肉眼是很难识别的。在 50% 的情况下人类是可以正确区分的,而且大部分是随机猜测。当AI通过大量的深度学习后,卷积神经网络可以在 87 %到 98 %的情况下正确区分视频画面里修改过的和未修改过的图像。

德国慕尼黑技术大学的研究人员还开发了一种名为 “XceptionNet” 的算法,它能快速发现发布在网上的伪造视频,除此之外,还可以用来识别互联网上的误导性视频。这个人工智能算法主要集成到浏览器或社交媒体插件中,在后台运行,如果它识别出被操纵的图像或视频,它就会给用户发布警告信息,向视频中涉及的人员透露他们被“伪造”了。

造假不如造回忆

仔细想一想,“造假”似乎总是让人有着不好的联想,尤其是多媒体的造假,更是怎么看都觉得可怕。然而,还是那句老话,技术是无罪的,有罪的是那些有着邪恶用心的人。

将AI造假术的使用者换一批人,是不是更能物尽其用呢?有人说,人会经历三次死亡:第一次是身体停止运转导致的生理上死亡;第二次是举行完葬礼代表你社会位置的消失;第三次是当世界上没人再记得你的时候,真正意义上的死亡。

当你的亲人即将离开这个世界的时候,你是否想过用科技的方式,将亲人的音容笑貌化为情感寄托,换一种形式陪伴在你身边呢?也许这样,也能让亲人的“第三次死亡”来得更慢一点。

目前,就已经有人通过语音合成技术记录下了自己的声音,将自己的声音载入了一个智能音箱,以此来确保即使在自己去世后,亲人也能与自己进行语音交互。

而如果能通过一张照片就换来亲人“栩栩如生”的动态,未尝不是人们一解相思之苦的办法。

AI造假短视频应该是一个不断提升价值的过程,而不是被宵小们所利用。一方面,AI可以建立丰富的数据库,依赖于深度学习来进行更多应用场景的选择,使得这些在视频里被“复活”的人们,能够在不同的场景里出现,满足人们的更多情感需求。另一方面,将造假变成造回忆,收集某个人的图像和音频素材,为用户个性化建模,实现一对一的记忆归属。

结论:

其实,我们完全不用把AI造假想得那么坏。技术不是目的,只是手段,找对了用途,“造假术”也是有情怀的。

【完】

智能相对论(微信id:aixdlun):深挖人工智能这口井,评出咸淡,讲出黑白,道出深浅。重点关注领域:AI+医疗、机器人、智能驾驶、AI+硬件、物联网、AI+金融、AI+安全、AR/VR、开发者以及背后的芯片、算法、人机交互等。